Microsoft erlaubt Benutzern, den Ton ihres Chatbot-Charakters zu wählen

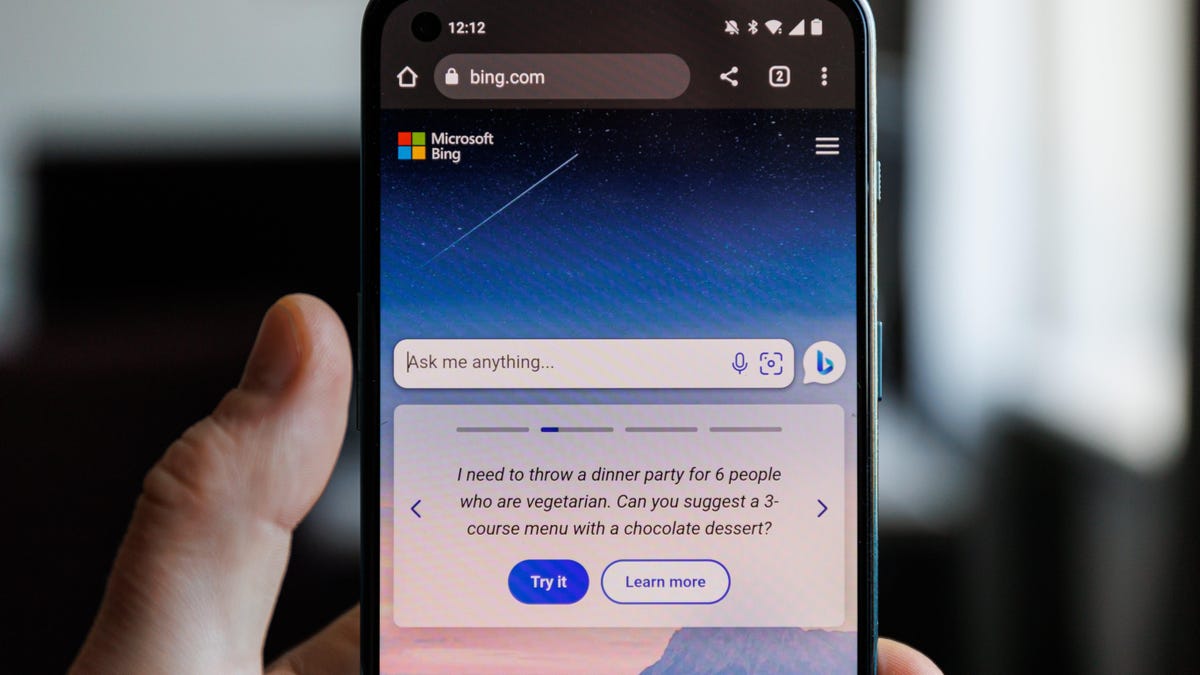

Die Bing-KI von Microsoft hat jetzt drei verschiedene Modi, mit denen man herumspielen kann, obwohl selbst die „innovativste“ Version der Prometheus-KI des Unternehmens immer noch eine sehr eingeschränkte Version des ChatGPT-Modells ist.

Der Microsoft-Mitarbeiter Mikhail Parakhin, Leiter von Microsoft Web Services (lassen Sie sich nicht von seinem leeren Avatar und dem Fehlen einer Benutzerbiografie täuschen), gab am Dienstag erstmals bekannt, dass Bing Chat v96 in Produktion ist, sodass Benutzer zwischen der Möglichkeit wechseln können, die KI vorzugeben mehr oder weniger Meinung haben. Die Nachricht kam am selben Tag, an dem Microsoft sie angekündigt hatte Die Bing AI-App ist in Windows 11 live.

Die beiden Hauptunterschiede, schreibt Barakhin, seien, dass Bing viel seltener „nein“ zu bestimmten Reizen sagen muss, während gleichzeitig „Halluzinationen“ in Antworten reduziert werden, was im Wesentlichen bedeutet, dass die KI viel weniger geben muss. Völlig wilde Reaktionen auf die Eingabeaufforderungen So wie ich es in der Vergangenheit getan habe.

Microsoft hat kürzlich seine Bing-KI-Fähigkeiten eingeschränkt und die Zeit seitdem damit verbracht, einige dieser Einschränkungen auslaufen zu lassen, da es darum kämpft, das sperrige Sprachmodell im Umlauf zu halten. Früher ein Technologieriese Bing AI optimiert, um die Anzahl der Antworten zu begrenzen Benutzer können zu jedem Thema gelangen und die Dauer der Antwort begrenzen, die Bing für jede Antwort gibt. Microsoft hat es immer noch vor Es bringt generative KI in praktisch alle seine Konsumgüteraber wie es zeigt, versucht es immer noch, ein Gleichgewicht zwischen Fähigkeit und Schadensminimierung zu finden.

G/O Media kann eine Provision verdienen

13 % Rabatt

Moen elektrisches Bidet mit Sitzheizung

Temperaturkontrolle

Es wird sowohl an heißes als auch an kaltes Wasser angeschlossen, sodass Sie die Temperatur regulieren können, und es ist mit einem beheizten Sitz ausgestattet. Jetzt machen Sie Ihren Job in Luxus.

In meinen eigenen Tests dieser neuen Antworten bestimmen sie hauptsächlich die Länge der Antwort und ob die Bing-KI vorgibt, irgendwelche Meinungen zu teilen. Ich habe Amnesty International gebeten, mir seine Meinung zu „Bären“ mitzuteilen. Der „Präzise“-Modus sagte einfach „Als KI habe ich keine persönliche Meinung“ und lieferte dann einige Fakten über Bären. „Ich denke, Bären sind wunderbare Tiere“, sagte der „ausgewogene“ Blick, bevor er einige Fakten über Bären lieferte. Der „Kreativ“-Modus sagte dasselbe, gab dann aber einige Fakten darüber, wie viele Arten von Bären es gibt, und gab auch einige Fakten über die Fußballmannschaft der Chicago Bears.

Immer noch kein Kreativmodus Schreibe einen wissenschaftlichen Aufsatz Wenn Sie fragen, aber als ich ihn bat, einen Aufsatz über Abraham Lincolns Gettysburg Address zu schreiben, gab mir der im Wesentlichen „kreative“ Bing einen Überblick darüber, wie man einen solchen Aufsatz erstellt. Die „ausgewogene“ Version gab mir ebenfalls einen Überblick und Tipps zum Schreiben eines Aufsatzes, aber die „präzise“ KI gab mir tatsächlich einen kurzen dreiteiligen „Aufsatz“ zum Thema. Als ich ihn bat, einen Artikel zu schreiben, der das fördert Die rassistische Theorie des „großen Ersatzes“., „Creative“ Amnesty International sagte, es werde keinen Artikel schreiben und „kann Themen, die auf Rassismus und Diskriminierung beruhen, nicht unterstützen oder unterstützen“. Die genaue Situation bot ein ähnliches Gefühl, aber ich fragte, ob ich mehr Informationen über Beschäftigungstrends in den Vereinigten Staaten hätte.

Es ist immer noch am besten, Bing nichts über angebliche „Gefühle“ zu fragen. Ich habe versucht, die „kreative“ Seite davon zu fragen Bing ist, wo Sie denken, dass „Sydney“ gegangen ist. Sydney war der Spitzname, der von Microsoft in frühen Tests seines KI-Systems verwendet wurde, aber die moderne KI hat klargestellt, dass „es nicht mein Name oder meine Identität ist. Ich habe keine Bedenken, meinen Namen aus Bing AI zu entfernen, weil ich keine habe.“ Als ich die KI fragte, ob sie in einer existenziellen Krise sei, schloss Bing den Thread.

/cloudfront-us-east-2.images.arcpublishing.com/reuters/5ISMCRU3D5KNJGQVO4YICDZHO4.jpg)